GPT-4V都考不过?基于大学水平考试的多模态AI测试基准MMMUs发布(gpt43)

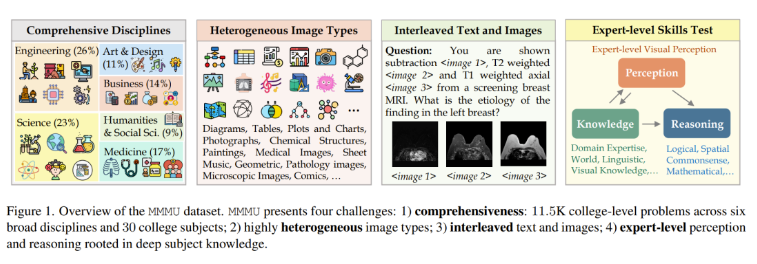

12月1日 消息:近日,一项基于大学水平考试的多模态AI测试基准MMMUs发布,旨在评估机器在广泛多样的任务上的专家级多模态理解和推理能力。这一基准对当前最先进的GPT-4V等模型提出挑战,通过涵盖艺术与设计、商科、科学、健康与医学、人文与社会科学、技术与工程等六个学科的30个科目,共有1.15万个问题,考察了感知、知识和推理等基本技能。

论文地址:https://arxiv.org/abs/2311.16502

项目网站:https://mmmu-benchmark.github.io/

数据集:https://huggingface.co/datasets/MMMU/MMMU

代码:https://github.com/MMMU-Benchmark/MMMU

MMMUs的问题涵盖了大学考试、测验和教科书,由50位来自不同学科的大学生收集,涉及了多种图像格式,从照片和绘画到图表和表格。这使得该基准不仅考察了常识和日常知识,还注重专业领域知识和高级推理。此外,MMMUs具有文本和图像混合的输入,要求AI模型在处理这种混合信息时展现深度学科知识和执行复杂推理的能力。

在实验评估中,MMMUs展现出极大的难度,即使是当前最先进的GPT-4V也仅在55.7%的问题上取得准确答案,表明AI技术在这一领域仍有巨大的改进空间。通过这一基准的构建和评估,研究团队为进一步推动人工智能系统的发展和深入研究提供了有力的工具和参考。

总体而言,MMMUs作为一项全面、具有挑战性的多模态AI测试基准,为评估专家级AGI的发展提供了新的视角和标准。这将有助于推动人工智能领域的发展,引领未来人工智能系统在多学科、多模态任务上取得更为卓越的成就。